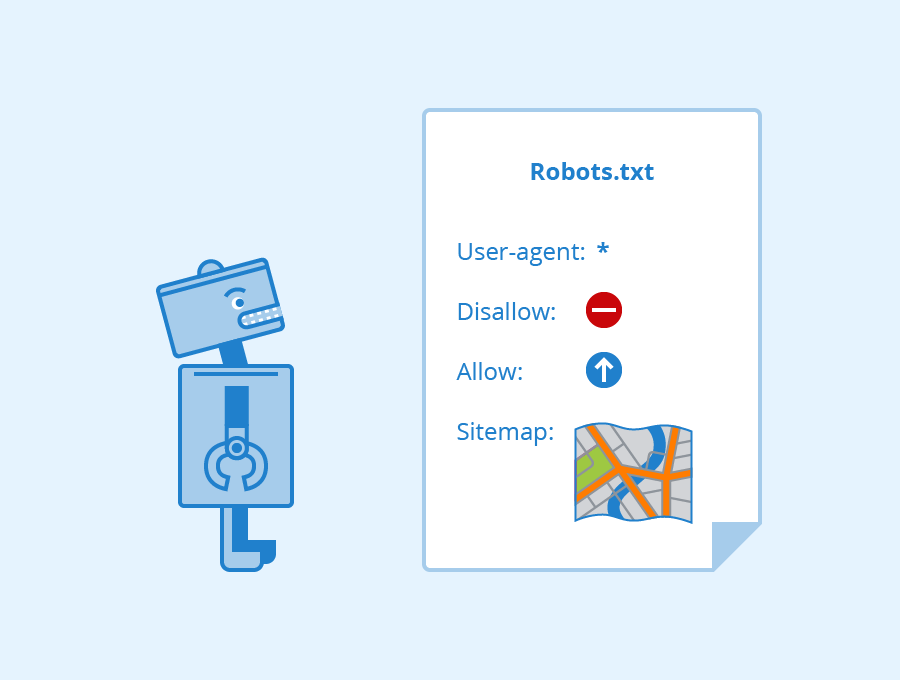

Robots.txt — co to jest i dlaczego ważne jest zarządzanie indeksowaniem?

Robots.txt to plik serwisowy zawierający reguły, według których pewne (lub wszystkie) boty wyszukiwarek mogą indeksować Twoją witrynę. Na przykład WordPress będzie automatycznie edytował plik, jeśli zaznaczysz ustawienie: „Proś wyszukiwarki o nieindeksowanie strony”. Za pomocą robotów można spróbować uniemożliwić indeksowanie witryny przez Google i pozostawić ją otwartą tylko dla Yandex, używając dyrektywy robots txt allow i disallow.

Co to jest plik robots.txt?

Robots.txt to prosty plik tekstowy o małej nazwie, znajdujący się w katalogu głównym witryny.

Jeśli umieściłeś go poprawnie, otworzy się on pod adresem: site.pl/robots.txt

Robots.txt — co to i dlaczego ważne jest zarządzanie indeksowaniem?

Jeśli Twoja strona jest w czystym HTML + CSS, tzn. każdą stronę robisz ręcznie, nie używasz skryptów i baz danych (strona 100 stron to 100 plików HTML na Twoim hostingu), to ten artykuł nie jest Ci potrzebny. W takich witrynach nie ma potrzeby zarządzania indeksowaniem.

Ale nie masz prostej strony firmowej z kilku stron (choć takie już od dawna powstają w CMS-ach typu WordPress/MODx i innych), a pracujesz z dowolnym CMS-em (a więc językami programowania, skryptami, bazą danych itp.) — wtedy spotkasz się z takimi „urokami” jak:

- duplikaty stron;

- śmieciowe strony;

- niedostateczna jakość stron i wiele innych.

Główny problem polega na tym, że do indeksu wyszukiwania trafiają rzeczy, które nie powinny się tam znaleźć — strony, które nie są przydatne dla ludzi i zapychają wyszukiwanie (więcej na temat tego problemu przeczytasz na https://sempai.pl/blog/robots-txt-czym-jest-plik-robots-i-do-czego-sluzy/).

Co powinno być zablokowane w pliku robots.txt?

Najczęściej indeksowane są następujące:

- Strony wyszukiwania. Jeśli nie zamierzasz ich moderować i pracować nad nimi – ich indeksowanie powinno zostać zamknięte.

- Koszyk na zakupy.

- Strony z podziękowaniami i składaniem zamówień.

- Czasami warto zamknąć strony z paginacją.

- Porównanie produktów.

- Sortowanie.

- Filtry, jeśli nie można ich zoptymalizować i moderować.

- Znaczniki, jeśli nie można ich zoptymalizować i moderować.

- Strony rejestracji i autoryzacji.

- Biuro prywatne.

- Lista życzeń.

- Profile użytkowników.

- Pliki i katalogi systemowe.

- Wersje językowe, jeśli nie zostały zoptymalizowane.

- Wersje do druku.

- Puste strony itp.

Zamknij wszystko, co nie jest przydatne dla użytkownika, nie jest gotowe, nie zostało ukończone lub jest duplikatem. Zbadaj swoją witrynę, korzystając z powyższych wskazówek, i sprawdź, jakie adresy URL są generowane w danych wyjściowych.

Previous Post

Previous Post Next Post

Next Post